-

Par la gazettemediatique le 22 Mai 2022 à 12:37

Un regard philosophique sur la gravité quantique qui mène vers Dieu

1) Qu’est-ce la gravité quantique ? Est-ce que les cosmologistes savent ce qu’ils cherchent en manipulant les équations et modèles formant un ensemble hétéroclite de descriptions microphysiques à base de spin, matrices, fonctions d’onde, et une description macroscopique quelque peu absconse fournie par les tenseurs de la relativité générale utilisés par Einstein ? Je crois surtout que les physiciens cherchent à élaborer en premier lieu une théorie mixte permettant de combiner les modèles quantiques et le modèle cosmologique établi avec les équations d’Einstein vénérées telles de saintes écritures mathématiques. Autrement dit, les physiciens sont en quête d’une cosmologie quantique. Avec comme obstacle la rencontre de signes mathématiques incompatibles. Ce qui oblige à élargir le spectre de la modélisation théorique. On l’a noté avec le résultat le plus commenté dans ce domaine, la dualité AdS/CFT établie par Juan Maldacena qui relie deux représentations, l’une contenant la gravité et l’autre dans laquelle la gravité est absente. Autrement dit, deux univers jouent de manière coordonnée mais dans le second, la gravité n’intervient pas dans le jeu. Plus précisément, l’espace AdS gouverné par la gravité possède une frontière bord, horizon, surface disposant d’une dimension en moins, dont le jeu est gouverné par une théorie conforme du champ. Tout se passe comme si l’espace AdS représente le monde réel qui viendrait se « plaquer » sur une surface représentant sa carte. Mais cette carte est interactive. Tout se passe comme si ce qui est calculé (anticipé, mémorisé) sur cet horizon pouvait se projeter et former une géométrie spatiotemporelle contenant une dimension de plus. Cette dualité est parfois interprétée comme un dictionnaire permettant de traduire dans le second monde ce qui se passe dans le premier et c’est assez troublant, comme si le réel était dédoublé à l’instar du monde platonicien constitué du sensible et de l’intelligible.

Le cosmos AdS est conçu à partir de la gravité déterminée par l’équation d’Einstein R = T. Cette équation permet de modéliser un cosmos constitué d’un bloc et par dérivation, de retrouver la mécanique classique de Newton. La gravité d’Einstein est bien plus qu’une mécanique et désigne l’instance physique qui règle la disposition des masses et la « forme » que prend l’étendue. Les masses façonnent la scène sur laquelle elles jouent et la gravité désigne l’instance qui impose les règles de ce jeu. Mais nous ignorons comment ces règles peuvent se transmettre et comment les masses « communiquent », voire « communient » et « conspirent » en quelque sorte pour façonner un cosmos. La correspondance AdS/CFT est purement formelle. Il faudrait lui donner un sens physique en introduisant un champ permettant aux signaux d’être véhiculés.

Il y a une différence d’approche et de finalité entre la cosmologie quantique pratiquée par les spécialistes de la physique mathématique et la gravité quantique regardée et comprise avec une approche héritée de la philosophie de la Nature, mais néanmoins dérivée des savoirs scientifiques disponibles à notre époque. La gravité quantique sera conçue comme un dépassement des limites de la cosmologie des physiciens. Plus précisément comme un principe systémique qui, pour être efficient, utilise la transmission de signaux quantiques, de bosons, voire de fermions, et dont l’intervention ne se réduit pas au réglage des masses et du cosmos. La physique quantique est une physique des communications (Dugué, 2017b). La gravité quantique est alors une sorte de « colle systémique » permettant de produire un cosmos en utilisant des signaux et des champs. Colle, certes, mais qu’est-ce qui est collé ? En apparence, cette colle invisible réunit les morceaux de matière et les fait tenir ensemble dans une disposition ordonnée qui n’est pas figée mais mobile. A chaque moment, la disposition change. La gravité est donc aussi ce qui produit le collage des moments successifs du cosmos. Autrement dit, ce qui fait que le cosmos ne se disperse pas et que ce qui est projeté soit dissout, que ce qui arrive dans le temps soit retenu pour faire place à une autre arrivée. La gravité est ce qui retient le « Temps » pour laisser de l’espace. Temps retenu, ou dissout ? La physique nucléaire pourrait livrer quelques explications et permettre une formulation quantique de la gravité. Cette physique n’est pas étrangère à la gravité avec son modèle standard qui recèle des énigmes mais aussi qui est partie prenante dans la théorie du champ conforme CFT utilisée dans la dualité jauge/gravité (AdS/CFT).

La gravité post-relativiste est un principe naturel (physique) dont les effets tiennent en quelques mots. Solidarité de toutes les choses disposées et coordination de la manière dont les choses se meuvent dans le cosmos en se manifestant. Pour résumer, les choses de la nature dépendent de deux types de « colle », le magnétisme et la gravité. Ces colles sont dynamiques, elles sont basées sur des signaux, des communications. Chacune est efficace dans son champ d’intervention spécifique. L’électrodynamique est responsable des réactions chimiques, des liaisons diverses dont les effets cumulés et combinés produisent les propriétés des matériaux, des éléments chimiques, du vivant. Deux effets sont produits, attraction et répulsion. Les combinaisons se font et se défont avec des durées variables. La gravité est la colle du cosmos qui règle les masses. Ses effets ont une durée colossale rapportée à une vie humaine ou même la longue « histoire » de sapiens. Il est possible que la gravité ne soit pas une véritable interaction mais plutôt une émergence produite par un énigmatique jeu des deux « forces nucléaires », la forte et la faible. Ce qui signifie qu’il faudrait renverser l’approche et partir du modèle standard des particules et de considérer la gravité comme une émergence et un principe qui rend consistant l’ensemble. Un schéma permet de résumer la complexité du monde naturel et du cosmos.

Champ électrodynamique quantique

↑↑↑ ↔↔↔↔↔↔ ↔↔↔↔↔↔↔ ↑↑↑

Charges Magnétisme quantique Charges

Champ de gravité quantique

↑↑↑ ↔↔↔↔↔↔↔↔↔↔↔↔↔↔↔↔ ↑↑↑

Masses nucléaires ↓↓↓ Gravité quantique ↓↓↓ Masses nucléaires

Ce schéma qui résume l’univers interprété par les sciences physiques est aussi un schéma débordant sur la pensée philosophique. Il résume une première distinction entre les deux physiques, champs et communications, disposition (Dugué, 2017a). Il est de plus en connivence avec la doctrine des deux matières formulée par Plotin dans le sillage de Platon et Aristote. Cette doctrine paraît obscure mais pourtant, elle est assez claire, séparant deux domaines ontologiques explicités avec le doublet matière et forme, liés à deux « ordres » du temps. La matière corporelle est considérée comme dépourvue de vie, de pensée, avec le caractère de la mort. A l’inverse, la matière divine possède une « vie intellective », son essence est à la fois engendrée et inengendrée (on retrouve ce double caractère dans les autoconstituants décrits par Proclus dans les éléments de théologie). Ces deux ordres du temps ont leur corrélat cosmologique, renvoyant aux deux mondes décrits par Aristote, sublunaire et corruptible, supralunaire et éternel. La physique moderne n’a pas réfuté ce schéma, elle l’a juste actualisé avec un coup de théâtre ontologique. La matière corporelle est étudiée par la thermomécanique, elle va vers la corruption et la mort, comme l’indique la seconde loi de l’entropie. En revanche, ce qui correspond à la matière divine est étudié par la mécanique rationnelle, interprétée par Prigogine comme physique de l’être, par opposition à la thermodynamique vue comme une physique du devenir. Le coup de théâtre n’est rien d’autre que l’unification du ciel et de la terre par la physique de Newton. La matière soumise à l’inertie ou à la gravité possède en quelque sorte le caractère de la matière divine, autrement dit, déterminée par une essence et le principe du Kosmos, qui essencialise, alors que le Kronos est une puissance génératrice autant que corruptrice (voir sur ce point, Dugué, 2017b).

« La matière divine, en recevant la forme qui la détermine, possède une vie intellectuelle et déterminée. Au contraire, lors même que la matière des corps devient une chose déterminée, elle n’est ni vivante, ni pensante ; elle est morte malgré sa beauté empruntée. La forme des objets sensibles n’étant qu’une image, leur matière n’est également qu’une image (εἴδωλον). La forme des intelligibles possédant une véritable réalité, leur substance a le même caractère. On a donc raison d’appeler essence la matière, quand on parle de la matière intelligible : car la substance des intelligibles est véritablement une essence, surtout si on la conçoit avec la forme qui est en elle ; alors l’essence est l’ensemble lumineux [de la matière et de la forme]. Demander si la matière intelligible est éternelle, c’est demander si les idées le sont : en effet, les intelligibles sont engendrés en ce sens qu’ils ont un principe ; ils sont non-engendrés en ce sens qu’ils n’ont pas commencé d’exister, que, de toute éternité, ils tiennent leur existence de leur principe ; ils ne ressemblent pas aux choses qui deviennent toujours, comme notre monde ; mais ils existent toujours, comme le monde intelligible. » (Plotin, Ennéades, traité II, 4, trad. Bouillet)

Il n’y a qu’un pas, certes de 17 siècles, pour disposer d’une philosophie distinguant autant les deux ontologies (en l’occurrence l’être et l’existant) et les deux compréhensions du temps avec la distinction entre historicité et historialité avec deux notions, la temporalité et la temporellité, élucidées dans Etre et Temps par Heidegger. Autrement dit, le temps biographique du devenir et le temps kosmologique qui caractérise l’essence de l’Etre. La dernière carte du jeu ne sera pas jouée. Augustin et le de trinitate nous conduirait trop loin. J’espère que les éveillés du nouveau commencement auront accès à ces quelques lignes écrites sur la gravité quantique.

2) Si la mécanique quantique règle les communications entre « particules », la gravité est ce qui émerge lorsque les particules ou essences élémentaires finissent par d’ordonner et façonner un cosmos mobile. La nature se présente avec des régularités............................................

Dugué, B., L’information et la scène du monde, Iste éditions, 2017a

https://iste-editions.fr/products/linformation-et-la-scene-du-monde

Dugué, B., Temps, émergences et communications, Iste éditions, 2017b

https://iste-editions.fr/products/temps-emergences-et-communications

Traduction anglaise

http://www.iste.co.uk/book.php?id=1199

http://www.iste.co.uk/book.php?id=1332

-

Par la gazettemediatique le 22 Mai 2022 à 12:29

La physique quantique pour les nuls en 10 épisodes

« Il n’y a plus rien à découvrir en physique aujourd’hui, tout ce qui reste est d’améliorer la précision des mesures. »

Citation du physicien Lord Kelvin en 1900.La physique du 19e siècle, la fin de l’histoire ?

Cette citation de l’un des plus grands physiciens du 19e siècle résume bien l’état d’esprit qui régnait dans le monde scientifique de l’époque. Nul ne s’attendait alors à ce que deux des principales théories admises comme des vérités ultimes allaient être remplacées en moins d’un quart de siècle.

On distinguait alors trois grands piliers théoriques dont un seul d’entre eux a survécu aux révolutions conceptuelles du 20ième siècle. Le premier pilier était basé sur la théorie de Newton avec la notion de matière possédant une masse et interagissant à distance à travers ce que l’on a appelé des forces. Le second introduisait le concept de champs ondulatoires immatériels dits électromagnétiques se propageant sans support apparent, la lumière visible étant une petite partie de cet ensemble. Enfin le troisième pilier qui de son coté a survécu est la thermodynamique traitant des échanges de chaleur et des conversions d’énergie.A l’époque, les scientifiques pensaient la matière était de structure particulaire et la lumière ondulatoire comme l’indiquait la célèbre expérience des fentes de Young en 1801 qui montrait des franges d’interférence lors de l’addition de deux rayons lumineux.

Il restait cependant quelques questions en apparence simples à élucider à savoir le mystère du corps noir et l’effet photoélectrique. Et ô surprise, ces dernières, loin d’être mineures ont conduit à la remise en cause de tout l’édifice.

Théorie quantique, une révolution de la physique au début du 20e siècle

Épisode #1 : Max Planck et les quantas

Max Planck mit en 1900 le premier coup de boutoir à la physique ondulatoire de la lumière en introduisant la notion de quantas lumineux, seule méthode permettant d’expliquer le problème du corps noir, la lumière devient donc une entité constituée d’un ensemble de petits paquets d’énergie indivisibles. Planck introduisit alors sa fameuse constante h qui est l’une des constantes fondamentales de l’Univers, on la retrouve sans surprises dans toute la mécanique quantique.

Épisode #2 : Albert Einstein introduit le photon

En 1905 à partir des travaux de Planck, Einstein poursuit dans cette voie en expliquant l’effet photoélectrique.

Lorsque l’on soumet une plaque métallique à un rayon lumineux à haute fréquence, alors la plaque émet des électrons. La théorie ondulatoire donnant des résultats incohérents, Einstein explique le phénomène en introduisant la notion de particules de lumières absorbées par la plaque, le photon était né.

Dans les calculs, l’énergie E du photon reste alors associée à une longueur d’onde λ par une relation simple dite de Planck-Einstein utilisant la constante de Planck h et c la vitesse de la lumière (E = h.c/λ). Plus la longueur d’onde est petite, plus l’énergie du photon est grande.C’est à cette date que la représentation mentale de la lumière se complique avec la notion de dualité, en effet cette dernière se présente « en même temps » comme une onde et comme une particule.

Remarque : il n’y a pas de limite théorique à l’énergie véhiculée par un photon, cependant les sources les plus puissantes détectées dans l’univers ont atteint les 450 TeV (téraélectronvolt).

Épisode #3 : Louis De Broglie subodore que la matière est aussi une onde

En 1924, Louis De Broglie va encore plus loin en présentant dans sa thèse sa fameuse hypothèse qui à l’instar des travaux d’Einstein sur la lumière associe également une onde à chaque particule matérielle de masse m comme par exemple un électron.

Cette idée est révolutionnaire.

En effet De Broglie est parti du fait que la lumière que l’on croyait purement ondulatoire s’est avérée être également de nature particulaire, il fit alors l’hypothèse que symétriquement la matière que l’on pensait purement particulaire pouvait également présenter une nature ondulatoire.

Cette hypothèse sera ultérieurement vérifiée par l’expérience de Davisson-Germer en 1927 qui réussit à faire interférer des électrons à l’identique de l’expérience des fentes d’Young avec la lumière.Épisode #4 : Erwin Schrödinger met tout cela en équation (Ψ)

C’est en 1925 que le physicien Erwin Schrödinger poursuit l’écriture de l’histoire, il prend la thèse de De Broglie sous le bras et, accompagné d’après la légende par l’une de ses maitresses [1] part en montagne pour réfléchir à la question de la dualité onde-particule afin de construire un formalisme mathématique.

En mécanique quantique du fait de cette dualité, la notion familière de trajectoire en mécanique classique n’existe pas. Il s’agissait alors pour Schrödinger d’imaginer des opérateurs mathématiques spécifiques basés toutefois sur un principe de correspondance avec la mécanique classique.

Partant alors de l’équation classique de la conservation d’énergie d’un système avec ses deux composantes cinétique et potentielle, il rechercha alors une fonction mathématique pour caractériser l’état quantique d’un système en fonction du temps.

Cette dernière appelée fonction d’onde fut nommée psi, elle est notée : Ψ. Elle est dite complexe car elle fait intervenir le nombre imaginaire i et pour chaque problème traité, il faut établir une fonction d’onde spécifique.

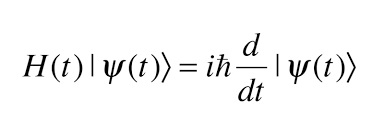

Pour déterminer la fonction Ψ, Schrödinger établit son équation éponyme qui est une équation complexe aux dérivées partielles en fonction du temps dont l’inconnue est la fonction d’onde Ψ.

On remarque que comme en relativité, le temps est considéré comme existant à l’extérieur du système [2].

Pour les curieux, voici la forme mathématique sous laquelle se présente cette équation dans le cas général [4] :

Elle caractérise l’évolution temporelle d’un système quantique par conservation de son énergie totale H (Hamiltonien). A noter que cette équation n’est valable qu’en dehors du cadre relativiste, soit en dessous de 10% de la vitesse de la lumière.

Sans entrer dans des détails techniques, il n’y a que dans des cas simples que l’on peut résoudre cette équation par détermination de solutions (Ψ1, Ψ2, etc.), pour les cas complexes il faut recourir à des simulations numériques sur ordinateur.

L’évolution de cette fonction dans le temps est déterministe mais elle n’est pas exploitable directement car elle est définie dans un espace dit de Hilbert sans rapport avec l’espace-temps dans lequel nous évoluons. Elle ne renseigne donc pas directement sur des valeurs de paramètres mesurables telles qu’une position ou une vitesse (voir ce cours ici).

Pour les cas relativistes, Paul Dirac partant du formalisme de Schrödinger a établi une équation compatible avec la relativité restreinte nommée « Équation de Dirac« . Il a été récemment démontré en 2018 par Nathalie Deberg (lien Journal Of Physics) que cette équation était compatible avec les énergies négatives du modèle cosmologique Janus [5].Lorsque Schrödinger a construit sa fonction d’onde, il n’a cependant pas immédiatement appréhendé sa signification exacte et ses implications.

Épisode #5 : Max Born et Niels Bohr donnent un sens physique à la fonction d’onde

Peu de temps après sa publication, Max Born et Niels Bohr donnent un sens à la fonction Ψ établie par Schrödinger.

A partir de conditions initiales définies Ψ (r0,t0), la valeur de la fonction à un instant t décrit l’état quantique du système étudié dans l’espace de Hilbert où il est définit. Il ne dit rien à ce niveau concernant des valeurs de mesures possibles.

Afin de pouvoir mesurer quelque chose et faire le lien avec l’expérience, il faut introduire la notion d’observables. Ces observable seront de deux types, soit elles ne peuvent prendre qu’un nombre fini de valeurs (ex : polarisation, spin), soit elles peuvent avoir n’importe quelle valeur (ex : vitesse, position). Dans ce second cas, on ne considérera un résultat de mesure possible qu’à l’intérieur d’une plage de valeurs (utilisation des écarts-types) car en physique quantique, tout est décrit par nature à l’aide de quantas.

Une observable est obtenue en effectuant une opération mathématique qui va décomposer la fonction Ψ en un ensemble de valeurs possibles qui seront alors susceptibles d’être mesurées, on parle de combinaison linéaire d’états propres. A chacune de ces valeurs pourra alors être évaluée une probabilité d’être mesurée par calcul du carré du module de l’état propre et la somme des probabilités de toutes ces valeurs sera de 100% (normalisation). C’est la même chose que pour un lancement de dé, il y a 6 valeurs possibles mais on ne peut pas déterminer celle du prochain lancer.

Il y a ensuite un aspect fondamental à considérer sur la question de la mesure d’un paramètre physique. En effet, toute mesure provoque une interaction entre l’objet mesuré et l’appareillage de mesure.

Comme on vient de le voir, avant la mesure le système est dans un état dit non déterminé, c’est à dire que cette dernière sera susceptible de prendre plusieurs valeurs possibles. Lors de la mesure, on dit que la fonction d’onde Ψ « s’effondre » en une valeur particulière.

Cette mesure va ensuite changer les conditions initiales de Ψ qui devra donc être mise à jour. Ψ(r,t) va ensuite recommencer à évoluer selon ce nouvel état initial jusqu’à la prochaine mesure ou interaction.Max Born établit également un principe fondamental de la physique quantique avec sa relation de non commutativité des vitesses et positions : pq-qp=-iħ

En clair cette relation indique que selon l’ordre dans lequel on effectue les mesures de vitesses et de positions, les résultats obtenus seront différents.

Cette formule fondamentale fut gravée sur la tombe de Max Born.D’après ce qui précède et selon l’interprétation dite de Copenhague, le comportement à très petite échelle est gouverné par le hasard, Einstein ayant une vision classique ne peut accepter cela et ainsi nait une controverse :

Einstein : « – Dieu ne joue pas aux dés ! »

Bohr : « – Einstein, arrêtez de dire à Dieu ce qu’il doit faire ! »Épisode #6 : Principe de superposition

Nous venons de voir que les équations ne permettent pas de calculer la valeur d’un paramètre de manière déterministe mais seulement de lui attribuer une probabilité de mesure parmi un ensemble de valeurs possibles. La question qui se pose et qui continue de faire débat plus d’un siècle après est de se représenter l’état du système juste avant l’opération de mesure.

Le système étant totalement indéterminé avant cette opération, il est supposé que ce dernier est constitué par la superposition de tous les états possibles, la mesure réduira cette situation en un seul état.Aristote avait établi un principe dit du tiers exclus qui lui semblait être un dogme intangible, en effet une porte peut être soit ouverte soit fermée, il n’y a pas de possibilité « tierce ».

En physique quantique, ce principe est en apparence violé, en effet si l’on prend l’image de la porte, alors tant qu’on ne la regarde pas cette dernière est dans un état indéterminé, elle est en même temps ouverte et fermée !

Selon la notation dite « bra-ket« , la fonction d’onde de la porte s’écrit : |Ψ(porte)> = |porte ouverte> + |porte fermée>

Si l’on tourne la tête vers la porte ce qui revient à faire une observation ou une mesure si l’on préfère, alors elle se fige en un seul état : « ouverte » ou « fermée ».

D’où une interprétation -qui continue à faire débat- en considérant que c’est l’action de prise de conscience d’une situation qui permet de fixer un système constitué d’états superposés à un état déterminé.Épisode #7 : selon Werner Heisenberg, il est impossible de prévoir en même temps la vitesse et la position

En 1927, Werner Heisenberg énonce son fameux principe d’indétermination qui contribua à son tour largement au débat sur la signification profonde de la théorie quantique.

Nous avons vu plus haut que pour les paramètres pouvant prendre une valeur quelconque (continue) comme la position ou la vitesse, alors il faut raisonner sur une plage de valeurs possibles ou écart-type σ (sigma).

Le principe d’indétermination d’Heisenberg indique que pour les paramètres vitesse (v) et position (x) d’une particule, la précision avec laquelle on peut connaitre simultanément ces deux paramètres est proportionnelle à la masse de la particule (σx.σv =<ħ/m).

Puisque les masses des particules élémentaires sont très faibles, cela signifie par exemple que si l’on connait la vitesse avec précision (+- 0.0001 m/s) alors on perd la précision sur la position (+- 1 km).

Ce principe correspond à une propriété physique, il n’est pas inhérent aux imprécisions de mesures.

Pour un objet macroscopique, sa masse étant très élevée alors la précision sur les deux paramètres peut être très grande, ce qui montre la compatibilité de ce principe avec la physique classique à notre échelle.

Terminons en précisant que ce principe est vrai également pour d’autres couples de paramètres que la vitesse et la position (Ex : énergie/temps).Épisode #8 : Principe d’exclusion de (Wolfgang) Pauli, le mystère du « spin »

Pour comprendre le principe d’exclusion de Pauli, il faut évoquer la notion de spin qui est l’un des paramètres quantique les plus étranges (Wiki). Il fut introduit par Wolfgang Pauli en 1924 dans les équations pour modéliser un comportement inexpliqué de l’électron (effet Zeeman).

Chaque particule quantique possède donc un spin qui conditionnera le comportement de cette dernière.

Ce paramètre est très difficile à interpréter car il ne possède pas d’équivalent en physique classique. Cependant pour se faire une idée approximative, on peut le comparer à une sorte de moment cinétique via une rotation de la particule sur elle-même selon une certaine vitesse et selon une certaine direction.

Puisque c’est un paramètre quantique, ce dernier est quantifié et il ne peut prendre qu’une valeur multiple de 1/2 et proportionnelle à la constante de Planck.

Une autre manière de représenter le spin consiste à le mettre en relation avec la notion de symétrie. La valeur du spin sera liée aux caractéristiques de symétrie spatiale de la particule considérée comme fraction d’un tour complet en rotation.

Par exemple, un as de cœur possède un spin de 1 car il faut un tour complet de la carte pour la retrouver dans le même état, le 2 de cœur quand à lui ne requiert qu’un demi tour, son spin sera donc de 1/2.Là ou cela se corse c’est qu’il existe des particules de spin 2 comme l’hypothétique graviton, ce qui signifie qu’il lui faut 2 tours pour se retrouver dans le même état. Le boson de Higgs quant à lui est de spin 0, ce qui pourrait évoquer pour ce dernier la topologie d’une sphère.

Le modèle standard de la physique des particules [3] classe alors ces dernières en deux grandes catégories selon leur valeur de spin avec des propriétés très différentes.

Les particules de spin entier ou nul sont appelées bosons et celles ayant un spin demi-entier (1/2, 3/2, 5/2…) sont nommées fermions.Et nous en arrivons enfin au principe d’exclusion de Pauli qui indique que deux fermions ne peuvent posséder simultanément les mêmes paramètres quantiques, en particulier pour leur position spatiale. Ce principe permet d’expliquer parfaitement la répartition des électrons en couche autour du noyau ainsi que toutes les règles sur la construction des atomes de tous les éléments possibles de la nature (tableau de Mendeleïev).

Plus trivialement, ce principe explique que puisque deux fermions (en gros « de la matière ») ne peuvent occuper la même position physique, alors si l’on s’assoit sur une chaise on ne passera pas au travers à cause d’interactions fortement répulsives entre les électrons des atomes !

A l’inverse, les bosons peuvent sans problème occuper un même point de l’espace, cela est illustré par le laser qui concentre une grande énergie en un seul point. Par ailleurs, ce sont des bosons qui servent de liants aux protons et neutrons constituant les noyaux atomiques.

Notons enfin que le photon sans masse qui est le boson de l’interaction électromagnétique possède l’équivalent du spin appelé polarisation, cette dernière peut prendre deux valeurs : +1 ou -1, l’électron quand à lui est un fermion avec également deux valeurs de spin possible : +1/2 ou -1/2.Une vidéo sur le spin ici.

Épisode #9 : Intrication quantique, la distance n’a aucune influence

L’intrication est un autre phénomène particulièrement contre-intuitif. Si deux particules (P1 et P2) ont été en interaction comme par exemple si elles sont issues de la désintégration d’une autre particule, alors ces dernières seront liées quelle que soit la distance qui les séparent, elles sont dites intriquées.

La mesure d’un état quantique sur l’une va certes obéir au calcul probabiliste avec les états superposés, cependant dès que l’on aura le résultat de la mesure de P1 alors on connaitra à coup sur la valeur du même paramètre sur la particule P2. Si les particules n’étaient pas intriquées, alors les valeurs de P1 et P2 seraient indépendantes.Prenons un exemple basé sur des photons, nous avons vu que le spin appelé polarisation pour ces particules peut être +1 ou -1. Pour deux photons quelconques, si l’on mesure la polarisation de l’un d’eux à 1, alors celle du second pourra être 1 ou -1. Si les deux photons sont intriqués, alors leur valeur de spin sera systématiquement inversée. Par exemple une mesure du spin à 1 sur le premier impliquera dans 100% des cas une mesure du spin à -1 pour le second.

Comment le photon mesuré peut il communiquer instantanément avec l’autre sachant qu’aucun signal ne peut dépasser la vitesse de la lumière ?Épisode #10 : Effet tunnel, une particule peut passer à travers un mur !

L’effet tunnel consiste en la possibilité pour une particule de traverser ce que l’on appelle une barrière de potentiel même si l’énergie de cette particule est inférieure à ladite barrière, la probabilité de traverser se calcule à l’aide de la fonction d’onde de la particule. En termes plus clair cela signifie qu’une particule peut comme par magie « passer au travers » une sorte de mur sans briser ce dernier.

La radioactivité alpha de l’Uranium 238 est un bon exemple d’effet tunnel. Le noyau U238 est constitué de 92 protons et 146 neutrons (92+146=238), à chaque composant de ce noyau est associée une fonction d’onde Ψ qui indique une probabilité de présence forte dans le noyau mais également faible à l’extérieur du noyau. On constate alors que des morceaux du noyau peuvent se retrouver spontanément éjectés à l’extérieur, ces morceaux sont constitués de 2 protons et 2 neutrons « collés », soit des noyaux d’hélium (4He). L’atome U238 sera alors transformé en thorium 234 constitué de 90 protons et 144 neutrons.

L’effet tunnel est très utilisé en électronique comme par exemple dans les transistors, composants de base des puces des ordinateurs. Il a également permis la technologie des disques SSD et autres clés USB où l’on fait entrer ou sortir par effet tunnel des électrons dans une cavité isolante (électrons présents -> bit = 1, électrons absents -> bit =0).

Après cette présentation assez complète de la théorie quantique en une série d’épisodes, nous pouvons synthétiser tout cela en une dizaine de lignes.

La physique quantique en 10 lignes

A la fin du 19e siècle, les physiciens croyaient à la fin de l’histoire avec la théorie de Newton basée sur des particules matérielles possédant une masse et l’électromagnétisme qui modélisait la lumière sous la forme d’ondes énergétiques pures. Deux problèmes en apparence mineurs ont induit l’élaboration d’une nouvelle théorie dite quantique complètement différente des précédentes avec des particularités très surprenantes.

Selon cette dernière, la lumière n’est plus seulement ondulatoire mais également particulaire, soit une nature duale. Ces particules de lumière ou quantas appelées photons présentent la caractéristique de pouvoir occuper un même point de l’espace. Les photons font partie de la famille des bosons qui servent de « colle » pour lier les particules de matière.

La dualité de la lumière fut étendue aux particules massiques de matière appelées fermions qui présentent également un comportement ondulatoire, il leur est cependant interdit d’occuper un même point de l’espace. Une propriété étrange des particules de matière est l’effet tunnel qui leur permet parfois de traverser une barrière sans la briser.

Ces concepts ont été modélisés mathématiquement avec la fonction d’onde psi qui a permis de prédire des résultats de mesures sous la forme de probabilités comme pour la météo signant ainsi la fin du déterminisme en microphysique.

Avant toute mesure ou interaction c’est à dire tant qu’on ne regarde pas, on considère qu’un système est constitué par la superposition de toutes les valeurs de mesures possibles et selon l’ordre dans lequel on effectue les mesures, les résultats seront différents.

Des particules ayant interagit ensemble sont dites intriquées, elles seront irrémédiablement et instantanément liées quelle que soit la distance qui les séparent.

L’interprétation de tous ces concepts continue de faire débat.Conclusion

Depuis des milliers d’années, il a été considéré comme évident que la matière était l’un des composants fondamentaux de l’Univers. Cependant, avec la science moderne qui a fait des pas de géants vers la connaissance du monde en profondeur, on s’est aperçus que plus on cherche la matière, moins on la trouve.

Il serait sans doute temps de revenir en arrière sur des croyances bien ancrées et de réfléchir à un changement majeur de paradigme en se posant les bonnes questions.

En effet, de quoi sommes-nous vraiment certains dans notre expérience quotidienne ?

La réponse est dans la question, la conscience est le seul élément de réalité dont l’existence ne peut être remise en question. Et donc si les matérialistes pensent que la conscience est une propriété émergente de la matière et que cette dernière ne semble correspondre à aucune réalité ontologique, ne serait il pas temps d’envisager une inversion de la cause et de l’effet [6] ?Références

[1] « Helgoland » – Carlo Rovelli – 2021

[2] « L’Ordre du Temps » – Carlo Rovelli – 2017

[3] Le Modèle standard de la physique

[4] Cours de physique en E-Learning (Chaine Youtube ici).

[5] « On evidence for negative energies and masses in the Dirac equation through a unitary time-reversal operator » – Journal Of Physics 2018 (Deberg, Petit, D’Agostini)

[6] « Physique quantique – L’esprit de la matière » – Vahé Zartarian (son site) – 2014 Suivre le flux RSS des articles de cette rubrique

Suivre le flux RSS des articles de cette rubrique