-

La France, pays "N°1 de la censure" sur Facebook ? Une présentation des données trompeuse

La France, pays "N°1 de la censure" sur Facebook ? Une présentation des données trompeuse

Attention aux chiffres censés prouver que la France est "numéro 1 de la censure" sur internet. Depuis fin novembre, de nombreuses publications sur Facebook affirment que la France est le pays qui "bloque le plus de pages sur les réseaux sociaux et internet que le monde entier réuni". Mais cette affirmation est trompeuse car elle se fonde sur des données anciennes et très partielles. Le nombre de contenus restreints ne concerne que Facebook, et ne portent que sur l'année 2015, année de plusieurs attentats meurtriers en France. A l'époque, les autorités avaient demandé le retrait de plus de 30.000 publications, qui diffusaient une photo de l'intérieur du Bataclan juste après la tuerie. A l'exception de cette année particulière, les contenus retirés par Facebook à l'issue de signalements sont plus faibles que dans d'autres pays, comme le montrent les données de Meta, maison-mère de Facebook. Pour autant, deux spécialistes interrogés par l'AFP, qui confirment le caractère trompeur de ces chiffres, pointent de potentielles atteintes à la liberté d'expression face à la modération des contenus en ligne par les plateformes.Depuis fin novembre, des dizaines de publications sur Facebook partagées parfois plusieurs centaines voire milliers de fois (ici, ici ou ici) affirment que les autorités françaises sont celles qui bloquent le plus de contenus en ligne, et de loin.

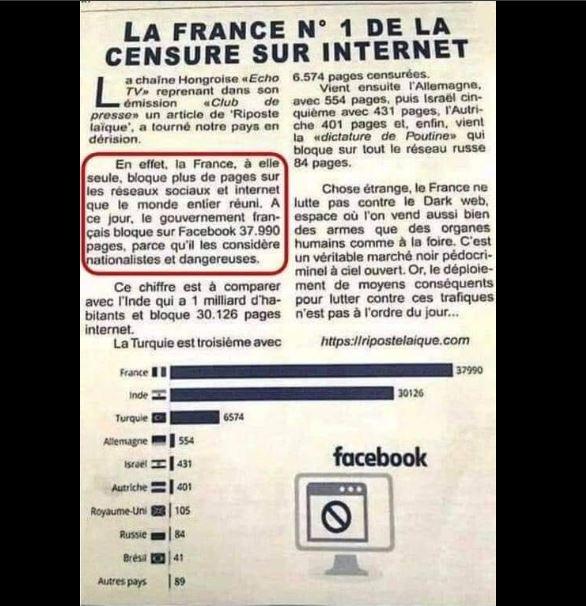

Toutes partagent la même capture d'écran d'un article de Morpheus, site qui déclare vouloir "sortir du sommeil de plomb de la pensée unique". Paru dans un numéro téléchargeable de novembre 2017, l'article met en avant des chiffres censés représenter la "censure sur internet". "A ce jour, le gouvernement français bloque sur Facebook 37.990 pages, parce qu'il les considère nationalistes et dangereuses", explique-t-il.

L'article présente un graphique, reprenant des données mises en avant par le site d'extrême-droite Riposte Laïque dès mai 2017, et qui présente la France comme le pays qui "bloque le plus de pages" , parfois loin devant plusieurs autres pays, comme l'Inde, la Turquie, l'Allemagne et la Russie.

"La censure en Russie. Ah non (...), c'est en Gaule", souligne ironiquement une publication.

Capture d'écran de l'article de Morpheus, partagé sur Facebook depuis fin novembre (capture du 30/11/2022)Image

Des données de 2015 concernant le retrait d'une photo des attentats du Bataclan sur Facebook

Mais ces chiffres, s'ils sont authentiques, sont à recontextualiser.

Tout d'abord, les données mises en avant ne portent que sur Facebook, et non sur "l'ensemble des réseaux sociaux et internet", comme le prétend l'article.

D'où sont issus ces chiffres ? Du centre de transparence de Meta (maison-mère de Facebook). Chaque semestre, Meta publie le nombre de contenus restreints sur Facebook et Instagram à la suite de signalements car contrevenant aux lois locales, ainsi qu'un rapport expliquant les raisons pour lesquelles ces contenus ont été restreints.

Qu'est-ce qu'une "restriction de contenu" au sens de Facebook dans ce cadre ? A la suite d'un signalement, la plateforme bloque l'accès à un contenu signalé - qui peut être une publication, une page, un commentaire ou encore un profil Facebook - dans le pays où il est présumé illégal, mais ne le supprime pas. Dans ces données sont comptabilisés les retraits liés à des signalements de la police, mais aussi des décisions judiciaires ou des signalements d'utilisateurs.

Dans cet article, les chiffres utilisés sont issus de l'année 2015, une année très particulière lors de laquelle la France a été affectée par les attentats meurtriers de janvier et du 13 novembre.

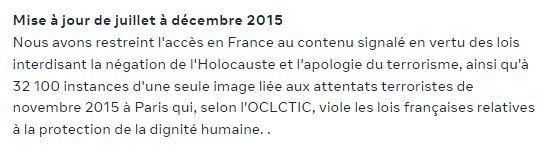

Comme l'explique le rapport de Meta pour le second semestre 2015, le grand nombre de contenus restreints au cours de l'année (37.990) est essentiellement lié au partage d'une photo de la salle de concert du Bataclan après l'attentat et qui montrait la salle de concerts jonchée de cadavres. Un contenu qui aux yeux de autorités françaises, "viol(ait) les lois françaises relatives à la protection de la dignité humaine".

Au total, Facebook dit ainsi avoir restreint l'accès à "32 100" contenus partageant cette image en France. Des contenus signalés à Meta par l'Office central de lutte contre la criminalité liée aux technologies de l'information et de la communication (OCLCTIC), un service notamment dédié au signalement et au traitement des contenus illicites en ligne.

Le reste des contenus restreints au cours de l'année en France sont liés à des signalements "en vertu des lois interdisant la négation de l'Holocauste et l'apologie du terrorisme", précise le rapport.

"Cet article [diffusé par les publications que nous examinons, NDLR] n’est pas mensonger mais il est trompeur", indique Romain Badouard, maître de conférences en sciences de l'information et de la communication à l'Université Panthéon Assas, interrogé par l'AFP le 29 novembre.

"Certes, les autorités françaises en 2015 ont fait beaucoup de demandes à Facebook. Mais ces demandes étaient liées à un contexte particulier qui n’est pas représentatif du comportement de la France vis-à-vis de Facebook", poursuit l'universitaire.

Capture d'écran du rapport du centre de transparence de Facebook pour le second semestre 2015 (capture du 30/11/2022)Image

Moins de 1000 restrictions de contenus par an en France depuis 2016

Ce n'est pas la première fois que ces chiffres ressortent sur les réseaux sociaux. En 2019, Libération avait déjà publié un article pour recontextualiser les données mises en avant dans ces publications.

Signe de l'exceptionnalité de l'année 2015, Facebook a restreint l'accès à seulement 35 contenus en France à la suite de signalements en 2014. Et le nombre de contenus et pages restreintes par Facebook en France a aussi beaucoup baissé dans les années après 2015 : sur les six dernières années, Facebook a ainsi restreint l'accès à moins de 1000 contenus ou pages par an en France. Et les raisons sont souvent diverses et pas uniquement liées aux demandes des autorités.

En plus des contenus faisant l'apologie du terrorisme et signalés par les services de police, Facebook a aussi procédé à des retraits de contenu à la suite de signalements d'internautes face à des publications à caractère diffamatoire ou des contenus niant l'Holocauste, ou a accepté des demandes de retrait effectuées par la justice française.

Sur la même période, Meta a restreint l'accès à près de 5000 contenus en moyenne par an en Allemagne, en Inde ou encore au Brésil, comme le montre le graphique ci-dessous et produit à partir des données du centre de transparence de Facebook pour les neuf pays représentés dans le graphique de l'article de Morpheus.

Une obligation pour Facebook de se conformer aux lois locales

Comment fonctionne la politique de restriction des contenus sur Facebook selon les pays ? Cette politique de restriction est à différencier de la politique de modération du réseau social, définie par ses Standards de communauté, et qui peut amener la plateforme à supprimer des contenus qui ne respectent pas ses règles.

En plus d'appliquer cette modération propre définie par les conditions générales d'utilisation de chaque réseau social, "qui peut aller au-delà de la loi", "une plateforme comme Facebook ou Twitter a une obligation de respecter la loi", explique ainsi Bastien Le Querrec, membre de La Quadrature du Net, association de défense et de promotion des droits et libertés sur Internet, à l'AFP le 28 novembre.

"Pour qu'un contenu soit restreint, il faut qu'il y ait une loi nationale qui interdise ce type de publication", souligne aussi Romain Badouard, par ailleurs auteur du livre "Les Nouvelles Lois du web : Modération et censure" (Le Seuil, 2020). "Dans un pays comme la France, on ne peut pas a priori faire taire un opposant ou un parti d'opposition".

Depuis 2004 et la loi sur la Confiance dans l'économie numérique, les réseaux sociaux comme Facebook ou Twitter, juridiquement irresponsables des contenus partagés sur leur plateforme, ont toutefois l'obligation de retirer tout contenu signalé qui contreviendrait à la loi française.

"Il existe des mécanismes où la justice ou la police peut notifier à ces plateformes un contenu qui serait contraire à la loi", précise Bastien Le Querrec. Le service de police Pharos, qui opère au sein de l'OCLCTIC signale notamment aux plateformes tout contenu qui lui paraitrait illégal au regard de la loi française.

En France, des restrictions des autorités notamment liées à la lutte contre le terrorisme

C'est notamment en s'appuyant sur la loi du 13 novembre 2014 relative à la lutte contre le terrorisme et la pédopornographie, qui a autorisé la mise en place de mesures administratives de retrait et de déréférencement auprès des plateformes que l'OCLCTIC a demandé à Facebook le retrait de la photo du Bataclan.

Des demandes ensuite "évaluées par Meta, pour vérifier la légalité de la demande", explique Romain Badouard. Contacté par l'AFP, Facebook a renvoyé vers les explications de son "Centre de transparence", qui explique comment chaque signalement est géré par la plateforme. La plateforme déclare notamment examiner chaque demande sur le plan juridique, mais étudie aussi si la demande est conforme sur le plan des droits de l'homme.

Si le nombre de restrictions a été faible au premier semestre 2022 en France (250), certaines ont toutefois eu un écho très important : à la suite de l'invasion de l'Ukraine par la Russie, 162 contenus et pages "représentant les médias contrôlés par l'Etat" comme Russia Today et Sputnik ont par exemple été interdits en France à la suite des sanctions européenne prononcées fin février.

"Nous avons reçu des demandes de plusieurs gouvernements et de l'Union européenne de prendre des mesures supplémentaires concernant des médias contrôlés par l'Etat russe", avait écrit Nick Clegg, vice-président de Meta, sur son compte Twitter. Il avait justifié la suspension par "la nature exceptionnelle de la situation".

Plus généralement, Bastien Le Querrec pointe toutefois un risque de "censure administrative", alors que les services de police effectuant les signalements peuvent "surinterpréter" le caractère illégal de certains contenus, notamment dans le cadre de la lutte contre le terrorisme.

"Est-ce que la police ne se trompe pas ? Selon les plateformes, certaines vont faire le choix de retirer les contenus signalés, d'autres non. Mais la seule notification par des services de police n'est en soi pas une notification d'illégalité", souligne-t-il. Un risque que tentent d'atténuer certains garde-fous comme l'Arcom ou la justice en cas de demande jugée abusive.

Mais qu'en est-il de ce genre de signalements dans des états possédant moins de garde-fous ? "Les plateformes sont obligées de se conformer aux lois du pays. Donc le problème qui se pose, dans des pays autoritaires est : comment arbitrer ce qui relève de l’atteinte à la liberté d’expression et ce qui relève d’une demande légitime ?"

Une modération désormais plus proactive des plateformes

En France comme à l'échelle de l'Union européenne, de nouvelles lois ont aussi poussé les plateformes à être plus actives dans la lutte contre la désinformation et la haine en ligne.

La loi de 2018 relative à la lutte contre la manipulation de l'information a notamment imposé de nouvelles obligations aux plateformes pour lutter contre les comptes "participant activement à la manipulation de l'information" ou à la "mise en place d'un dispositif de signalement", comme l'a rappelé récemment le dernier rapport de l'Arcom sur le sujet en novembre 2022.

Depuis 2021, les plateformes ont aussi des nouvelles obligations de moyens contre la haine en ligne et s'exposent à une sanction de l'Autorité publique française de régulation de la communication audiovisuelle et numérique (Arcom, ex-CSA) en cas de non-respect, comme l'explique l'instance sur son site. Plus récemment, le Digital Services Act (DSA) adopté à l'échelon européen devrait aussi accentuer dans les prochaines années la législation française sur la régulation des contenus en ligne.

Par ailleurs, Facebook, pressé d'agir à l'échelle internationale à la suite des critiques liées à la prolifération de fausses informations sur sa plateforme lors de l'élection présidentielle américaine de 2016, a notamment lancé un programme de lutte contre la désinformation et la mésinformation (Third Party Fact-checking program) en collaboration avec des dizaines de médias dans le monde dont l'AFP, pour mieux identifier et évaluer des publications partageant des fausses informations en ligne.

La même année, la plateforme de Menlo Park a par ailleurs adopté une stratégie de modération plus ferme de retrait de contenus qui ne respectent pas leurs conditions d'utilisation et de réduction de la propagation de contenus définis comme "problématiques".

Une stratégie pouvant provoquer à terme des pratiques excessives dans la modération des publications et autres pages sur la plateforme. Car au-delà des contenus retirés après un signalement, les deux spécialistes interrogés par l'AFP décrivent une modération pro-active de plus en plus poussée qui peut parfois "aller au devant des propos qui pourraient être illégaux dans différents pays", comme le souligne Romain Badouard.

Ce dernier pointe notamment des risques d'atteinte à la liberté d'expression face aux nouvelles politiques de modération et de restriction des contenus appliquées par les plateformes elles-même

D'où un dilemme difficile à résoudre pour les plateformes face à un "double problème", mis en avant par le chercheur : "d’un côté, on reproche aux plateformes de ne pas assez modérer et de laisser passer des messages de haine et d’apologie du terrorisme. Et de l’autre on les accuse de trop en faire et d’être des censeurs. La ligne médiane est donc très fine pour trouver comment modérer de manière légitime sans censurer."

Les bureaux de Meta à Menlo Park, en Californie, le 9 novembre 2022. ( AFP / JOSH EDELSON)Image

NB : Comme rappelé ci-dessus, l'AFP est partenaire de Facebook, dans le cadre du Third Party Fact-checking program (TPFC). Toutes les informations liées à ce partenariat sont disponibles ici.

« Départ à l’étranger : attention aux mauvaises surprises au moment de la successionTwitter files : «Preuve est faite que ces méthodes de censure, que beaucoup soupçonnaient, existent» »